Das chinesische KI-Startup DeepSeek hat gerade sein neuestes Large Language Model (LLM), DeepSeek-V3-0324, offiziell veröffentlicht. Mit einer Kapazität von bis zu 641 GB wurde dieses Modell auf der Hugging Face AI-Plattform angekündigt, ohne dass viele Informationen preisgegeben wurden – ganz im Sinne des gewohnten Geheimniskrämerei-Stils des Unternehmens bei neuen Produkten.

Das Besondere an diesem Modell ist die MIT-Lizenz, die eine freie kommerzielle Nutzung ermöglicht. Erste Benchmark-Ergebnisse zeigen, dass DeepSeek-V3-0324 auf gängigen Hardwarekonfigurationen wie Apples Mac Studio mit M3-Ultra-Chip läuft. KI-Wissenschaftler Awni Hannun berichtete, dass mit dieser Konfiguration eine Verarbeitungsgeschwindigkeit von über 20 Token pro Sekunde erreicht werden konnte. Die Möglichkeit, ein großes Sprachmodell auf Standardhardware vor Ort auszuführen, steht im krassen Gegensatz zum traditionellen Ansatz, komplexe Rechenzentrumsinfrastrukturen zur Unterstützung fortschrittlicher KI-Modelle zu nutzen.

Laut DeepSeek haben erste Tests deutliche Verbesserungen gegenüber früheren Versionen gezeigt. Das Modell wurde von internen Stakeholdern rigoros getestet und zeigte eine hervorragende Leistung. Es übertraf sogar alle Konkurrenzmodelle und schlug Anthropics Claude Sonnet 3.5 bei Aufgaben, die kein Deep Learning erfordern. Im Gegensatz zu Sonnet-Modellen, die ein kostenpflichtiges Abonnement erfordern, kann DeepSeek-V3-0324 jedoch völlig kostenlos heruntergeladen und genutzt werden.

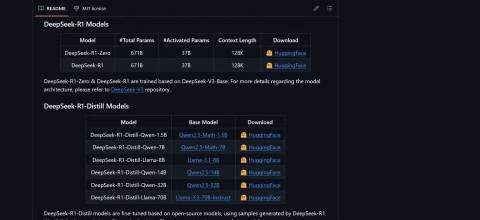

Technisch gesehen verwendet DeepSeek-V3-0324 eine Mischung aus Experten (MoE)-Architektur. Es zeichnet sich durch die selektive Nutzung von etwa 37 Milliarden der 685 Milliarden Parameter für jede Aufgabe aus. Dies erhöht die Effizienz durch reduzierten Rechenaufwand bei gleichbleibender Leistung. Das Modell nutzt außerdem die Technologien Multi-Head Latent Attention (MLA) und Multi-Token Prediction (MTP), die zu einem verbesserten Kontextspeicher und einer schnelleren Ausgabe beitragen.

Nutzer können auf Wunsch über Hugging Face, die Chat-Schnittstelle und API von OpenRouter sowie die Chat-Plattform von DeepSeek auf DeepSeek-V3-0324 zugreifen. Der Inferenzdienstleister Hyperbolic Labs bietet ebenfalls Zugriff auf das Modell.

Mit der Veröffentlichung von DeepSeek-V3-0324 behauptet das Unternehmen weiterhin seine Position im Wettlauf um die Entwicklung großer Sprachmodelle und bietet gleichzeitig eine leistungsstarke und zugängliche Option für die KI-Forschungs- und Entwicklungscommunity. Die Möglichkeit, auf Standardhardware zu laufen, gepaart mit einer kostenlosen Lizenz, wird diesem Modell in naher Zukunft sicherlich viele Möglichkeiten für die praktische Anwendung eröffnen.